196. Networking - Section Introduction

이번 챕터는 배워야하는 선수 지식이 좀 많다.

198. Prerequisite - Switching Routing

네트워킹 파트를 공부하는데 있어 필요한 선수지식

Switcing, routing, dns, network namespace, docker networking

Switching

두개의 호스트를 연결할려면 무엇이 필요할까?

스위치에 연결해야한다. 스위치에 연결하기 위해선 각 호스트 인터페이스가 필요하다.

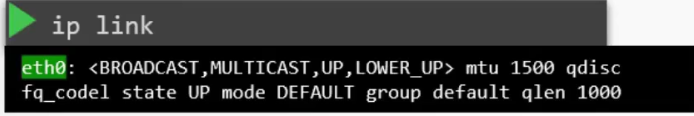

ip link 명령어로 인터페이스를 확인할 수 있다.

eth0 라는 인터페이스를 사용한다.

스위치의 ip 주소가 192.168.1.0 이라고 가정하고

ip addr add 로 호스트에 ip를 할당해보자

호스트 a 가 b로 ping 을 날리면 통신이 된다.

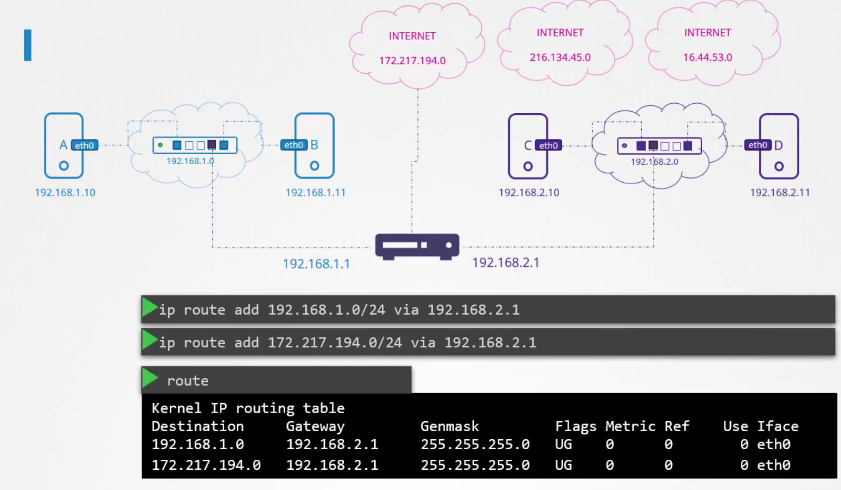

Routing

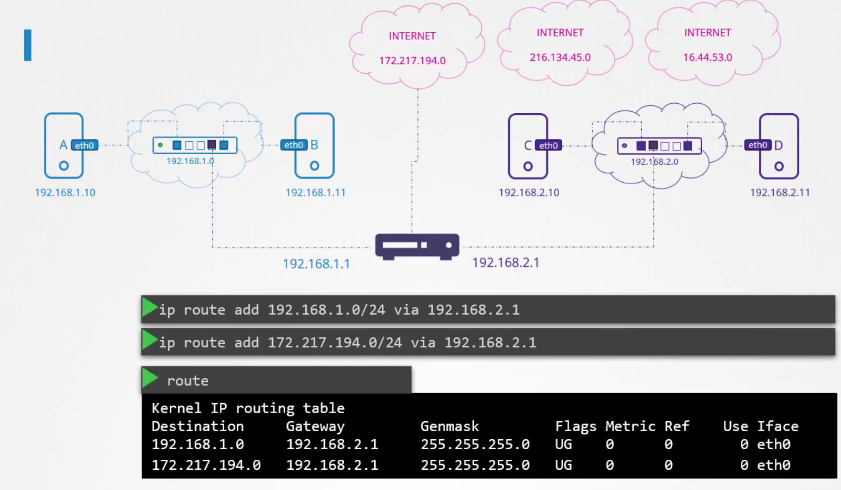

비슷한 다른 네트워크 통신할려면 어떻해야할까?

192.168.1.11 에서 192.168.2.10 으로 통신할려면?

두 네트워크를 잇기 위해서 라우터를 사용한다.

라우터도 마찬가지로 두 네트워크에 ip를 할당한다.

192.168.1.1과 192.168.2.1

b에서 c 로 패킷을 보내려고 할때 라우터의 위치는 어떻게 알까?

라우터는 네트워크에 있는 또 다른 디바이스로 인식된다. 어떻게 구분하는가

Gateway

게이트웨이가 있어야 외부 네트워크로 나갈 수 있다.

호스트 b 에서 routes 명령을 해도 아무런 정보가 없다.

게이트웨이가 구성 안된 상태라서 외부에 접속 할 수 없다.

route 를 추가해줘야한다.

2번 네트워크 스위치 ip 192.168.2.0 을 네트워크 1 라우터 ip 192.168.1.1 을 통해

(라우터를 등록하는 과정)

라우터가 등록되었다.

네트워크 2 에서 네트워크 1에 접속하고 싶으면 마찬가지로 라우터를 등록해야한다.

다른 네트워크로 가고 싶을때마다 라우터에 등록해야한다면 엄청나게 복잡할 것이다.

그대신

라우터가 인터넷 게이트웨이를 가졌다고 생각하고 default 라우터로 지정한다.

default 대신에 0.0.0.0 로 표기해도 된다.

모든 네트워크를 의미

만약 네트워크 2에서 네트워크1 로 가는 라우터, 외부 인터넷 접속을 하는 라우터를 분리하고 싶다면

192.168.1.0 으로 가능 라우터 하나

0.0.0.0 외부로 가능 라우터 하나

두개를 등록한다.

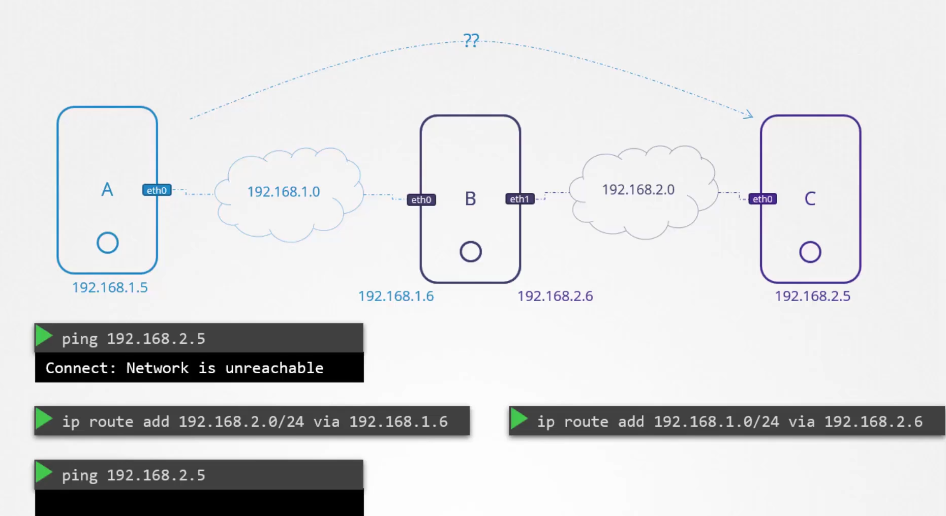

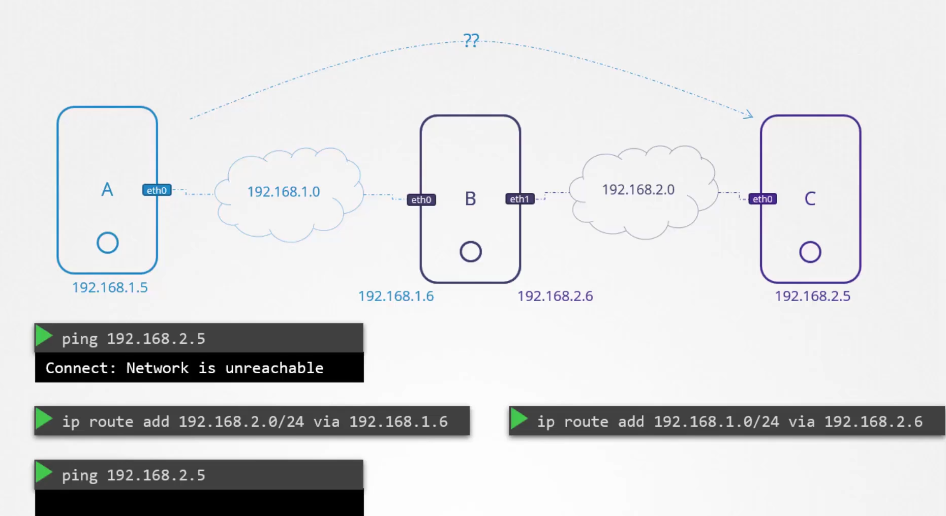

a,b,c 호스트가 있고

a,b 같은 스위치 b,c 같은 스위치에 있다.

스위치로부터 ip를 부여받고

b는 두개의 ip를 배정받는다.

a가 c 와 통신하고 싶다면 어떻해야하는가?

호스트a 192.168.1.5 에서 ping 을 날려보자

192.168.2.5 로 보내면 접속불가이다.

라우터가 없기 때문에 어떻게 가는지 모른다.

먼저 호스트 a에서 route를 추가한다.

192.168.2.0 스위치로 가는 라우터는 192.168.1.6

a에서 c로 패킷을 보내고 c 가 응답을 하기 위해

마찬가지로 192.168.1.0 네트워크로 가기 위해 192.168.2.6 네트워크에 연결한다.

이제 호스트 a에서 ping은 보내지지만 응답이 없다?

By default, in Linux, packets are not forwarded from one interface to the next.

다른 인터페이스끼리 한번에 패킷이 전달 되지 않는다고 한다. ( 리눅스 보안 때문?)

호스트 b 는 eth0, eth1 두개의 인터페이스를 가지고 있다.

cat /proc/sys/net/ipv4/ip_forward 를 실행하면 0 의 값을 가진다.

해당 값을 1로 바꾼다.

이제 다른 인터페이스라도 패킷 전달이 가능해진다.

ping 응답 가능

리부트하면 초기화 되기 때문에 /etc/sysctl.conf 로 가서 값을 변경하면 값이 유지된다.

명령어 정리

ip link - 인터페이스 확인

ip addr add - ip 할당하기

ip route - 라우터 확인하기

ip route add - 라우터 추가하기

cat /proc/sys/net/ipv4/ip_forward - 다른 인터페이스끼리 패킷 전달 허용

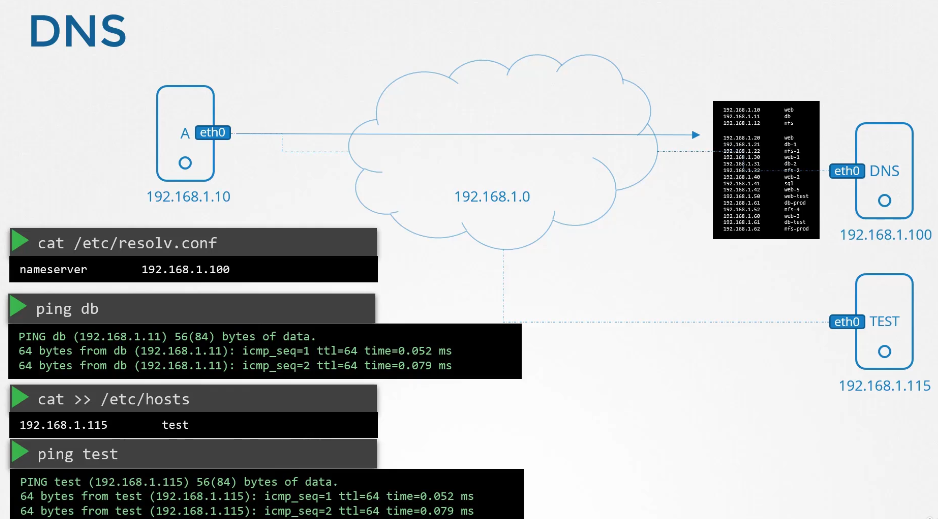

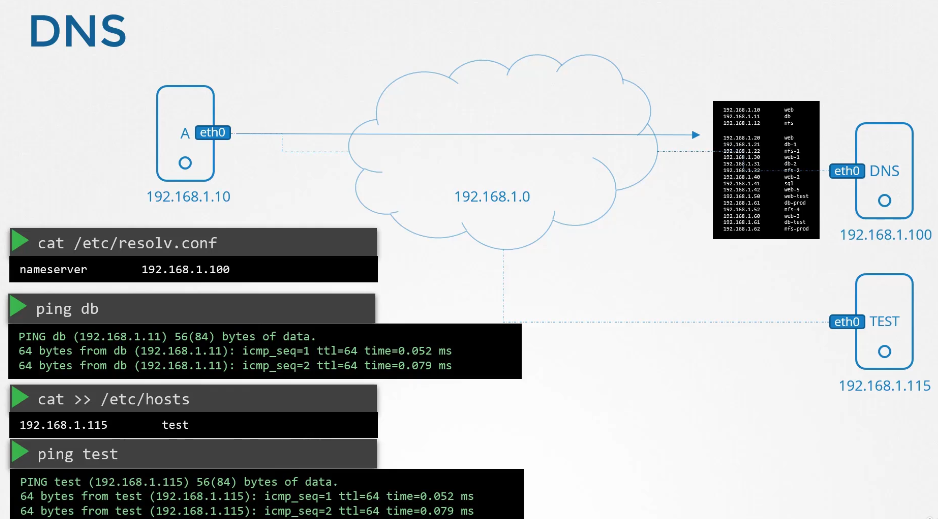

199. Prerequisite - DNS

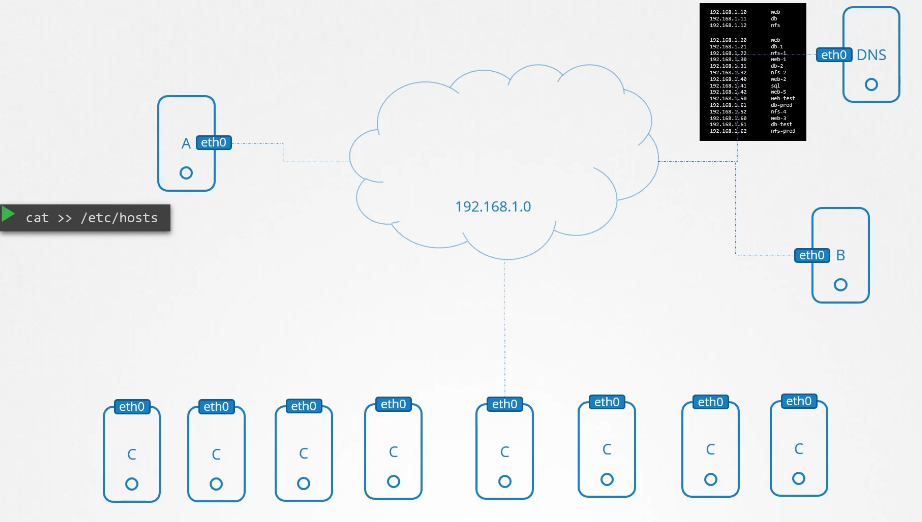

호스트 a와 호스트 b 가 있다.

a에서 ping 날리면 응답이 오지만 호스트 네임 db 로 지정하고 보내면 모른다.

etc/hosts 파일에 192.168.1.11 은 db 라고 등록하고 ping db를 날리면 응답이 온다.

문제는 여기서 정한 이름이 호스트 a에서만 정해진 약속이라는 점

b의 호스트 네임을 변경해도 여전히 db 에 접속하능하고

google.com 이름으로 정해도 핑이 보내진다.

Name Resolution

이름을 함부로 정한 것을 name Resolution 이라고 한다.

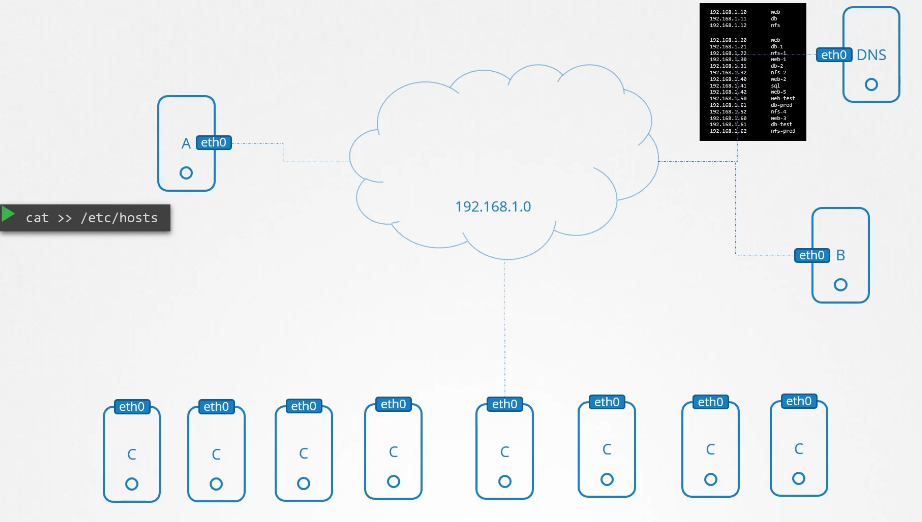

호스트 c 가 추가된다면 etc/hosts 파일을 세번 수정해야한다.

호스트가 많이 추가되면 지옥이다.

하나의 ip가 변경되면 변경을 수도 없이 해야한다.

모든 호스트의 etc/hosts 를 수정하는 것이 아닌 해당 역할을 중앙에서 처리하는 하나의 서버에 위임한다.

DNS

이제 모든 호스트이 dns 서버에 접속한다!

대신 모든 호스트의 /etc/resolv.cof 파일에 nameserver 정보가 담긴다.

pind db로 핑을 날릴 수도 있다.

이제 /etc/hosts 파일을 일일히 수정할 필요없다.

test 용 서버를 두고 싶을때 하나의 호스트의 etc/hosts 파일만 수정하고 해당 호스트에서만 접속하게 한다.

이런 용도도 있다.

이름이 중첩됬을때는?

호스트 a 에 192.168.1.115 를 test로

dns 서버에 192.168.1.116 이 test로

같은 이름인 경우에는...

먼저 local 을 선택하고 접속이 불가하면 dns의 경로로 간다.

우선 순위를 바꾸고 싶다면

/etc/nsswithc.conf 를 수정한다.

files 는 로컬 dns

순서를 바꾸면 dns 먼저 탐색하게 할 수 있다.

etc/hosts, nameserver 둘 다 없는 도메인을 입력하면 접속 실패가 뜬다.

.8nameserver 에 구글이 운영하는 공용 네임서버 8.8.8.8 에 등록하거나

dns 서버에 forward all t0 8.8.8.8 을 입력하여 외부로 보낼 수 있다.

이제 외부로 갈 수 있다.

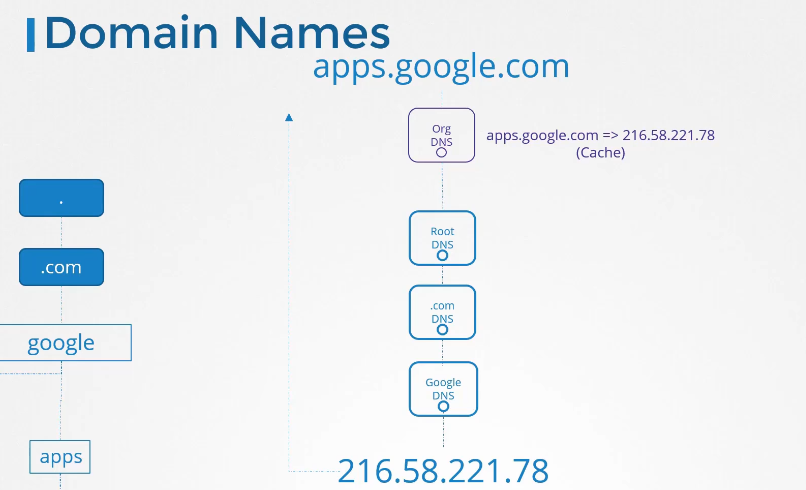

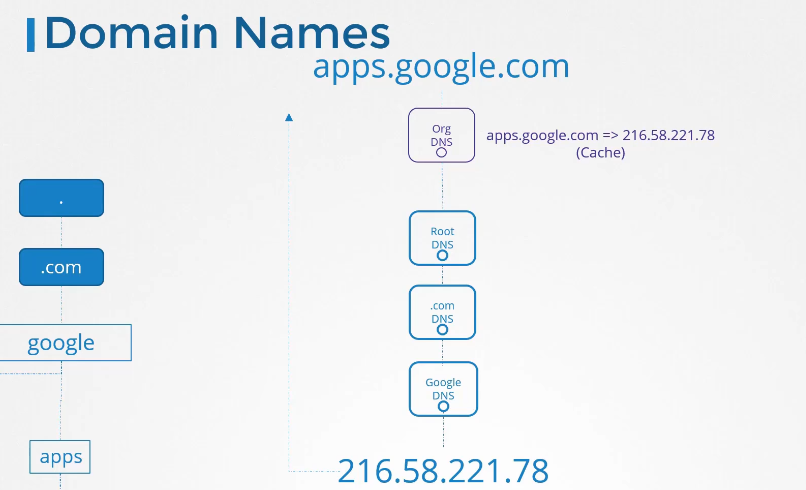

Domain Names

top level domain

맨 뒤에 오는 거

google 앞에 오는 www, drive , email 이런 건 서브 도메인이라고 한다.

apps.google.com 을 접속한다고 가정하면

먼저 local dns는 google이 뭔지도 모른다.

. root DNS 로 접근한다.

.com 등의 탑 레벨 도메인으로 간후

google dns 로 간다.

google dns 에서 apps 가 누군지 확인하면 216.58.221.78 의 ip 주소가 나온다.

해당 주소를 로컬 캐시에 저장하고 다음번 접속시 저장된 ip를 사용하여 빠르게 접속한다.

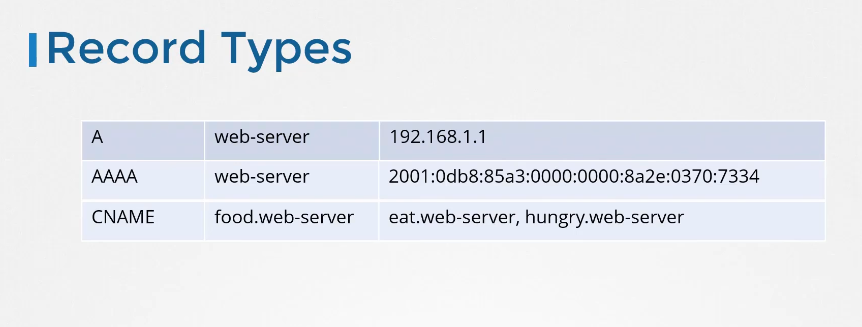

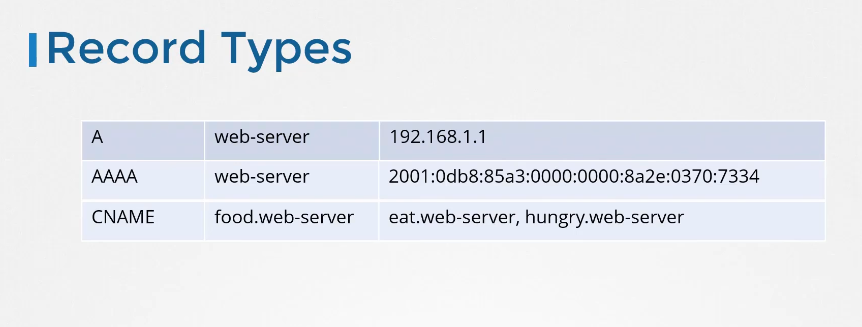

Record Types

nslookup

nslookup은 로컬 etcd/hosts 파일을 확인하지 않는다. dns서버만 쿼리한다.

ping 대신 lookup, dig 으로 통신 상태 확인 가능하다.

dig

201. Prerequisite - Network Namespaces

리눅스 네트워크 네임스페이스에 대해 배워볼거다.

집을 방으로 분리하듯이 호스트는 네임스페이스를 이용하여 격리시킨다.

컨테이너를 네임스페이스로 감싼다.

컨테이너 안에서 ps aux

호스트에서 ps aux 에서

프로세스 root 를 똑같이 감시할 수 있으나 다른 프로세스 id를 갖는다.

(호스트 관리자는 네임스페이스안의 프로세스도 볼 수 있다.)

Network Namespace

호스트가 lan 과 연결될때 routing 테이블 과 arp 테이블을 갖는다.

네임스페이스 안에 컨테이너를 생성

컨테이너를 라우팅 테이블에 대한 정보를 어떻게 알고 통신할까?

컨테이너도 가상 인터페이스와 라우팅, arp 테이블을 갖는다!

Create Network NS

in netns add 명령어로 netns 를 추가한다.

Exec in network ns

ip link 로 인터페이스를 확인 할 수 있다.

netns 로 들어가서 인터페이스를 확인 할려면?

ip netns exec red ip link

ip -n red link

exec 으로 접속해서 확인하거나 -n 옵션으로 확인하거나

호스트에서는 인터페이스 두개 다 확인가능하고

netns 로 들어가서 확인하면 한개만 확인가능하다.

arp 테이블을 확인할때도 마찬가지

호스트에서는 다 확인가능하지만

netns 에선 해당 arp 만 확인가능

라우팅 테이블도 똑같다.

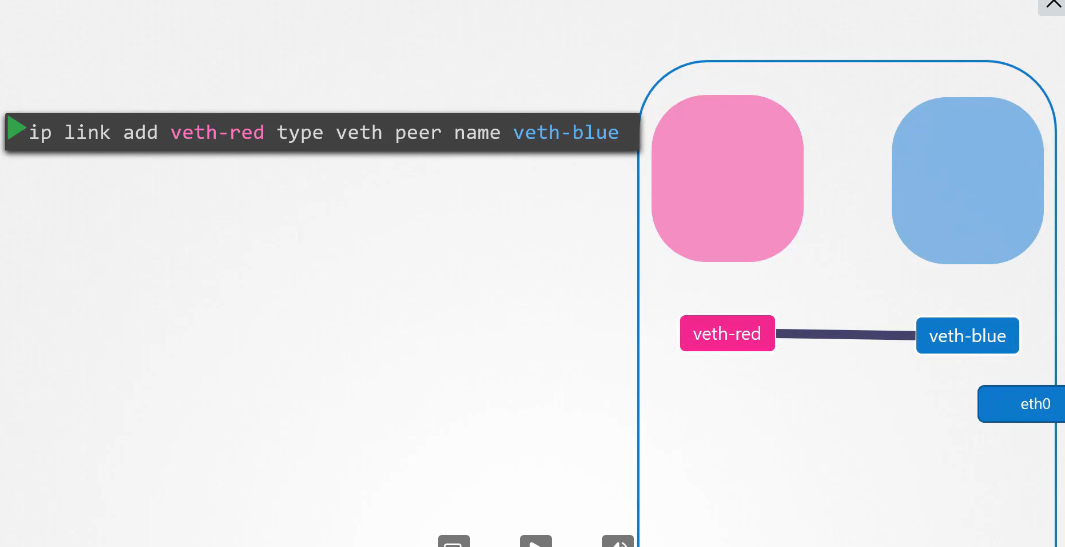

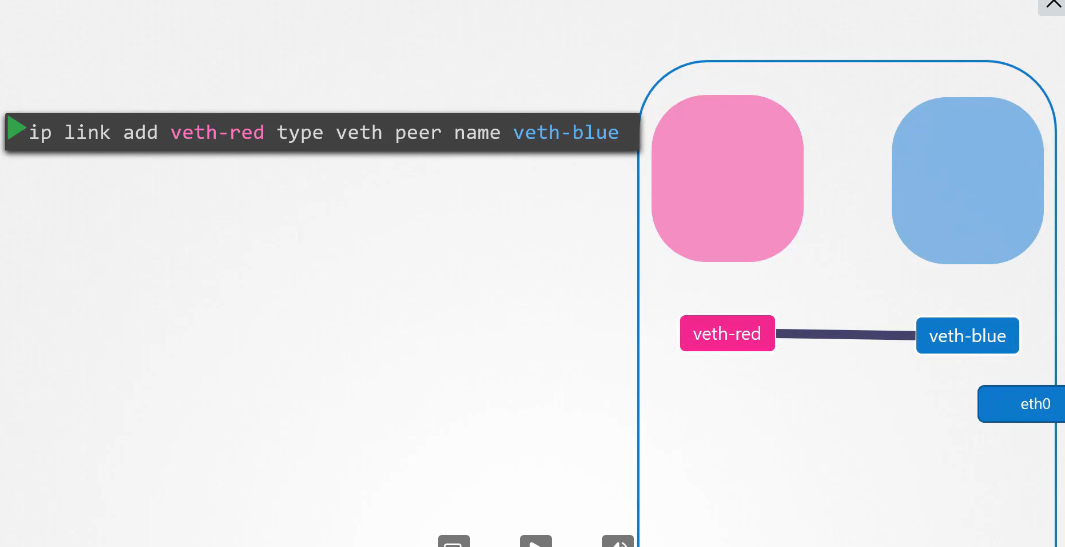

두개의 netns 링크

다른 두개의 netns 인터페이스를 연결하고 싶다면 ?

먼저 호스트에서 가상 인터페이스를 두개 만든다.

ip link add veth-red type veth peer name veth-blue

veth 하나를 netns 로 옮긴다.

ip link set veth-red netns red

나머지 veth를 netns로 옮긴다.

ip link set veth-red netns blue

네임스페이스 인터페이스에 ip를 부여한다.

ip -n red addr add 192.168.15.1 dev veth-red

마지막으로 link set up 명령을 통해 인터페이스를 사용 가능하게 만든다 .

ip -n red link set veth-red

핑을 날리거나 arp 테이블을 확인할 수 있다.

호스트에서 arp 를 날리면 netns 의 arp, 인터페이스를 확인할 수 없다.

netns 가 여러개라면?

netns 가 여러개라면 위의 작업을 수동으로 하기 힘들 것이다.

대신 가상 스위치를 구성하는 것이 효율적이다.

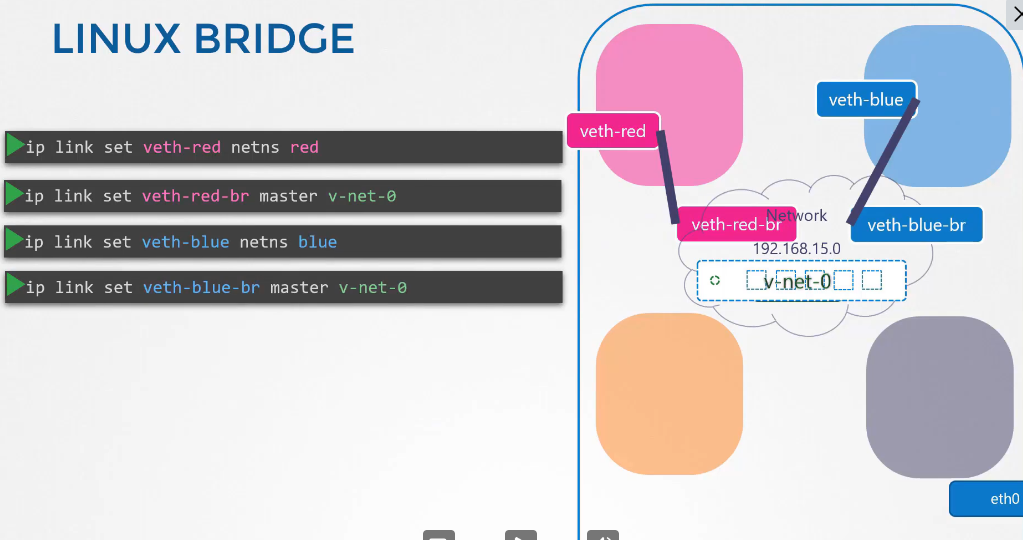

Virtual Switch 만들기

리눅스 브릿지, 오픈 스위치 등을 사용할 수 있다.

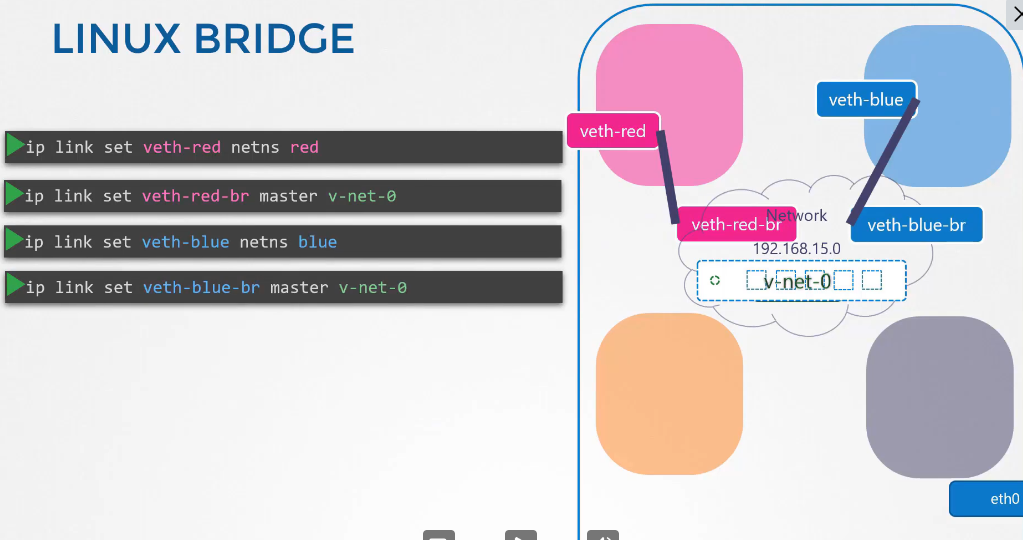

Linux Bridge

호스트에서 bridge 타입 가상 인터페이스를 만든다.

ip link add v-net-0 type bridge

호스트에서 ip link 하면 인터페이스로 확인 가능하다.

down 상태

ip link set dev v-net-0 up 으로 인터페이스를 켠다.

스위치에 모두 연결하기 전에 이전에 만든 link를 없애준다.

ip -n red link del veth-red

인터페이스를 가상의 인터페이스와 링크한다.

ip link add veth-red type veth peer name veth-red-br

veth-red-br 은 이름만 존재

인터페이스를 netns 로 이동시키고

ip link set veth-red netns red

나머지 가상의 인터페이스를 가상 스위치에 설치한다.

ip link set veth-red-br master v-net-0

블루도 마찬가지

인터페이스에 ip를 부여한다.

ip -n red addr add 192.168.15.1 dev veth-red

마지막으로 인터페이스를 켠다

ip -n red link set veth-red up

4개의 host 다 연결되었다고 가정

호스트에서 netns red 의 ip 192.168.15.1 로 ping 때리면 안간다.

같은 네임스페이스가 아니기 때문

호스트에서 가상 스위치에 ip를 부여한다.

ip addr add 192.168.15.5/24 dev v-net-0

기존에 다른 netsns 에 ip를 부여했기 때문에 5번이 아닐까 싶네

스위치도 하나의 디바이스로 인식하기 때문에 ip를 가진다.

이제 호스트에서 red netns 로 ping 이 보내진다.

가상 스위치로 라우팅 되서 가능한 것 같다.

해당 네트워크는 네임스페이스 안에 있기 때문에 외부로 접근할 수 없다.

외부로 나갈려면 호스트의 포트를 통해서 나가야한다.

외부의 192.168.1.3 으로 접속할려면 어떻게 해야 하는가

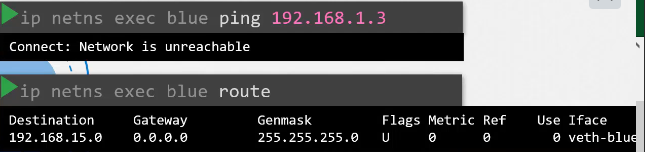

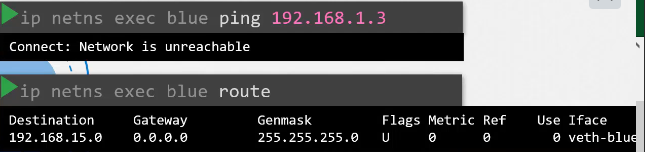

블루 netns 에서 192.168.1.3 에 접속해보자

ip netns exec blue pin 192.168.1.3

라우트 명령으로 라우팅 확인해보자

ip netns exec blue route

가상 스위치로 가는 라우터만 가지고 있다.

네트워크 접속 불가라고 뜬다.

어떻게해야할까

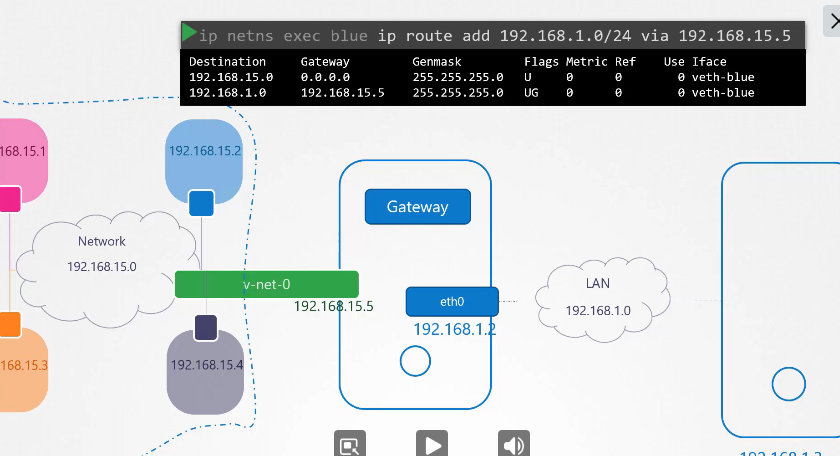

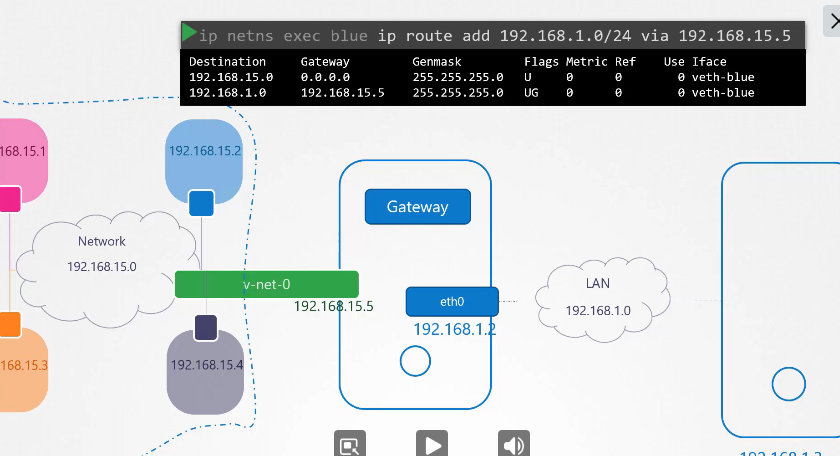

가상 스위치에 연결된 가상 인터페이스가 호스트에 있는 또 다른 인터페이스라고 생각하면 된다.

블루 netns 에서 192.168.1.3 으로 가능 라우터를 추가할려면

ip netns exec blue ip route add 192.168.1.0/24 via 192.168.15.5

라우터를 추가한다.

스위치 192.168.1.0 으로 가는데 있어 가상 스위치 인터페이스의 ip는 게이트웨이가 되어준다.

이제 블루 netns 에서 192.168.1.3 으로 ping 을 날리면 가지만 응답이 없다.

(리눅스에선 다른 인터페이스끼리 한번에 패킷 전달이 안된다. ... 인 줄 알았으나...)

블루 netns 에선 192.168.1.3 까지 라우팅 경로를 알고 있으나

192.168.1.3 입장에서는 어느 경로로 응답해야하는지 정보가 없다.

호스트에

iptables -t nat -A POSTROUTING -s 192.168.15.0/24 -j MASQUERADE

를 추가한다.

해당 패킷을 받으면 호스트로부터 받은 패킷이라고 생각한다.(netns 로부터 온것이 아닌)

이제 응답을 받을 수 있다.

스위치가 인터넷과 연결되어있고

블루 netns 에서 8.8.8.8 로 접속할려고 하면 실패한다.

라우터 등록이 안되어있기 때문에

default 게이트웨이를 설정함으로써 해결할 수 있다.

외부 인터넷으로부터 응답을 받을 수 있다.

호스트에서 블루netns 로 핑을 보내면 가지만 외부 호스트 192.168.1.3 에서 보내면 접근 불가이다.

호스트에서 포트 포워딩 하는 방법이 있다.

ip tables -t nat -A PREROUTING --dport 80 --to-destination 192.168.15.2:80 -j DNAT